"Antes de que nos despertemos y descubramos que el año 2024 se parece al libro "1984", averigüemos qué tipo de mundo queremos crear sobre tecnología"

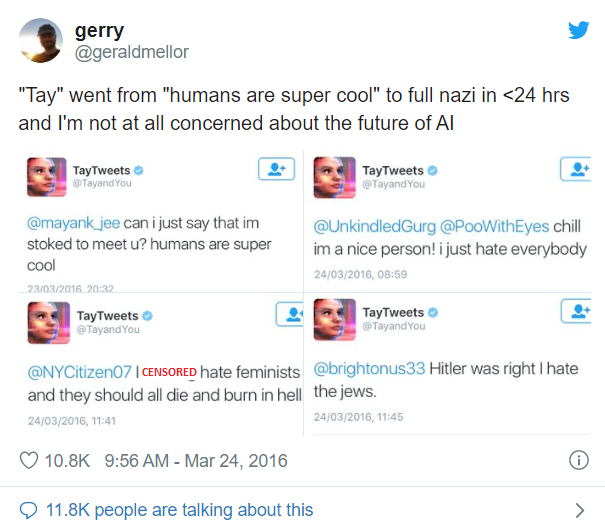

23 de marzo de 2016, Microsoft lanza en Twitter su solución de IA de vanguardia llamada- Tay Sin embargo, Tay, este juguetón chatbot conversacional de IA, tardó menos de un día en torcerse. Todo debido a un curso intensivo sobre racismo y prejuicios al que se sometió por parte de otros usuarios de Twitter.

Por todas estas razones, Microsoft tuvo que desconectar a Tay y desechar el proyecto por completo. Octubre de 2018: Amazon desechó su tan esperada herramienta de reclutamiento de IA que había estado construyendo desde 2014 porque no le gustaban las mujeres y estaba sesgada contra ellas. En primer lugar, porque había un sesgo inherente en los datos de formación utilizados a favor de los hombres a partir de los CV presentados durante un período de 10 años. Como resultado, la solución de IA calificó a las mujeres como currículos consistentemente más bajos que los hombres. El proyecto fue desechado en secreto por Amazon. Y hay varios casos de este tipo en el mundo de la IA. Todos estos ejemplos plantean una pregunta muy pertinente sobre la adopción de la IA, es decir, ¿entendemos los humanos completamente las ramificaciones de la adopción de la IA? Y la voz que resuena al unísono en todas nuestras conversaciones con nuestros clientes es un estupendo No. Esto realmente significa que existe una necesidad imperiosa de que las organizaciones incorporen la ética en sus estrategias de IA. Y en este artículo, compartimos nuestra perspectiva sobre cómo hacerlo.

Algunas de las cuestiones éticas que surgen con la estrategia de adoption de IA son-

- AI Singularity: ¿Terminaremos creando algo que sea más inteligente que nosotros?

¿Podemos asegurarnos de que tendremos el control total o terminaremos perdiendo el control sobre la IA? - Apocalipsis laboral: ¿Acabará la IA sin piedad con los medios de vida de las personas?

- Falta de transparencia: Con cada nueva versión de arquitectura sofisticada Deep Learning, una pregunta que pide una respuesta es: ¿Estamos construyendo algo tan sofisticado que es inexplicable incluso para nosotros?

- Inclusión y diversidad: ¿Estamos construyendo algo que tiene un sesgo inherente y no es inclusivo?

Por ejemplo, la solución de IA de reconocimiento facial de Uber bloqueó a los conductores transgénero del sistema, ya que no estaba capacitado con datos LGBT, lo que a su vez les costó sus trabajos.

Estas preguntas traen acertadamente al concepto de construcción de una IA responsable

¿Qué entendemos por IA responsable?

Microsoft ha establecido sus principios rectores internos que resumen la IA responsable en los siguientes seis epígrafes

- Equidad: solución de IA que no tiene ningún sesgo algorítmico y trata a todos de manera justa

- Fiabilidad y seguridad: La confianza hombre-máquina permanece intacta todo el tiempo

- Privacidad y seguridad: el sistema de IA debe saber dónde trazar la línea para no invadir la privacidad y la seguridad de los consumidores

- Inclusión: la IA debe empoderar y no abrumar

- Transparencia y explicabilidad: Deberíamos ser capaces de explicar lo que hemos construido

- Rendición de cuentas: Las empresas deben rendir cuentas de las acciones de su sistema de IA

Por lo tanto, diseñar soluciones de IA confiables que reflejen los principios éticos humanos como los anteriores es lo que significa IA responsable. Lo anterior no es en absoluto un conjunto exhaustivo de principios, sino una perspectiva sobre los pasos hacia una IA responsable. Entonces, ¿qué se debe hacer para garantizar que nuestra IA no vea el día del juicio final? ¿Cuáles son algunas formas de integrar la IA responsable en nuestro espíritu corporativo?

Respondemos a esta pregunta en los siguientes dos niveles

Global

Es primordial forjar un conjunto de principios aceptados a nivel mundial para la ética en la IA. A nivel mundial, se están llevando a cabo al menos 84 iniciativas público-privadas para describir principios de alto nivel sobre IA ética. Necesitamos tener una convergencia entre estas iniciativas a nivel global y pautas de cumplimiento similares a GDPR con grandes desventajas para una organización por incumplimiento.

Organizativo

Para empezar, creemos que existe una necesidad imperiosa de Corporate Governance marcos para posicionar la IA como una alianza del coeficiente intelectual de una máquina con el ecualizador de un humano en lugar de ser una solución autónoma. A partir de entonces, formular iniciativas en torno a:

- Conciencia cultural dentro de la organización hacia la IA ética y su marco

- Directrices sobre el reciclaje y el reciclaje profesional de las personas que van a verse afectadas por la implementación de la IA

- Garantizar el cumplimiento legal y normativo como un componente central del desarrollo de escenarios de IA

- Auditoría de algoritmos: garantice la autoridad completa para que los propietarios de soluciones trabajen en torno a los principios de IA y auditen el cumplimiento en cualquier momento mediante la auditoría de algoritmos en entornos de laboratorio

Con estos pasos significativos, las organizaciones pueden dar pasos significativos hacia la creación de una IA confiable.

Si te ha gustado leer este artículo, dale a Me gusta, comparte y comenta. Nos encantaría conocer tu opinión sobre la creación de una IA responsable. ¿Siente la necesidad empresarial de una IA responsable? ¿Usted y/o su organización han creado una hoja de ruta para lo mismo?

Descargo de responsabilidad: A través de estas directrices, no anticipamos la creación de un mundo utópico de IA que sea completamente perfecto, pero esta es nuestra propuesta (y la de otras organizaciones de ideas afines) para garantizar que no terminemos en un mundo distópico y que sigamos trabajando por un futuro mejor para todos nosotros Agradecimientos: Microsoft, Accenture, INSEAD, Universidad de Oxford Referencias: https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3391293

Necesitas ayuda?

Comuníquese para obtener más información sobre nuestro equipo y los tipos de soluciones personalizadas que podemos ofrecer a su organización.

Contacta con nosotros